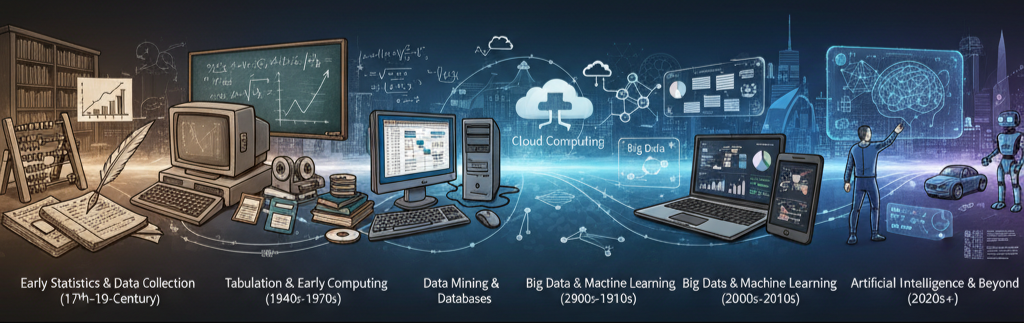

Desde sus raíces en la estadística hasta su actual enfoque en la inteligencia artificial, la Ciencia de Datos (Data Science) ha experimentado una profunda redefinición de sus bases teóricas. Esta evolución ha marcado una transición de la búsqueda de la certeza matemática a la priorización de la utilidad empírica, la integración computacional y, finalmente, la capacidad algorítmica.

I. La Fundación Filosófica y Empírica (Décadas de 1960 y 1970)

Los fundamentos de lo que hoy conocemos como Ciencia de Datos se establecieron cuando destacados pensadores desafiaron la primacía de la estadística matemática y el rigor deductivo:

A. Data Analysis: Priorizando la Utilidad sobre la Seguridad (John W. Tukey, 1962)

El estadístico John W. Tukey fue fundamental al argumentar que el análisis de datos debía ser reconocido como una ciencia en sí misma, distinta de las matemáticas.

- Ciencia de la Experiencia: Tukey sostuvo que la validez del análisis de datos debe depender del "prueba de la experiencia" (el test de la experiencia), y no meramente de la consistencia lógica o la prueba matemática.

- Juicio sobre Prueba: En este nuevo campo, la acción se guía por la búsqueda de "alcance y utilidad en lugar de seguridad". El análisis debe estar dispuesto a cometer errores moderados si esto permite sugerir la respuesta correcta con mayor frecuencia. Tukey criticó que el argumento y los resultados matemáticos fueran utilizados como "bases para la prueba o sellos de validez", en lugar de bases para el juicio.

- Peligros de la Optimización: Tukey alertó sobre los peligros de la "ossificación" de la estadística causada por el énfasis excesivo en la optimización (hallar la "mejor" solución) según criterios precisos, pero a menudo inadecuados o demasiado simplificados. La ciencia avanza más al "meliorar" (mejorar) un problema complejo que al optimizar uno simple.

B. Datalogía: El Estudio de la Descripción (Peter Naur, 1966)

Casi simultáneamente, en el campo de la computación, Peter Naur propuso una nueva denominación académica.

- Descripción como Núcleo: Naur argumentó que la designación más adecuada para la computación como campo académico era "datalogía", definida como "el estudio de los datos y los procesos de datos".

- Naur enfatizó que el núcleo de la ciencia y la erudición no reside en la lógica o la causa, sino en la descripción. Por lo tanto, la computación tiene sentido como una "forma de descripción".

II. La Expansión Formal y el Imperativo Computacional (Principios de 2000)

A principios del siglo XXI, William S. Cleveland formalizó un plan de acción para renombrar y reestructurar el campo de la estadística, integrando la computación como un pilar intelectual indispensable.

A. Ciencia de Datos: Foco en el Analista

Cleveland propuso el término "ciencia de datos" (data science) para el campo modificado y puso el foco central en el analista de datos en ejercicio.

- Valor del Trabajo Técnico: El valor del trabajo técnico se juzga por la medida en que permite al analista "aprender de los datos".

- La Computación se Une a la Matemática: El plan de Cleveland estableció seis áreas técnicas críticas, entre ellas "Computing with Data" (Computación con Datos). Se abogó por que la informática se uniera a las matemáticas como un área de competencia central para la ciencia de datos. La computación abarca hardware, sistemas de software y algoritmos, un área que necesitaba muchos más recursos y que ha demostrado ser una fuerza poderosa para la innovación (como el caso del sistema S de John Chambers, ganador del ACM Software System Award).

- Teoría No Matemática: Cleveland subrayó que "no toda teoría es matemática". Las teorías más fundamentales, como la teoría bayesiana de la inferencia inductiva, son esencialmente no matemáticas, ya que se refieren a la combinación de información de los datos con información externa.

III. La Bifurcación Metodológica: Las Dos Culturas (Leo Breiman, 2001)

La llegada de algoritmos computacionales potentes y el crecimiento exponencial de los datos forzaron una división fundamental en la metodología del campo, descrita por Leo Breiman como "Las Dos Culturas":

A. 1. La Cultura del Modelado de Datos (Data Modeling)

- Modelo de Generación: Esta cultura, que representa aproximadamente el 98% de los estadísticos, asume que los datos son generados por un modelo subyacente simple (ej., regresión lineal) más ruido.

- Objetivo: Se enfoca en la información (aprender sobre la naturaleza subyacente del proceso).

- Validación: Se basa en la bondad del ajuste (goodness of fit) y el examen de residuos.

- Limitación Clave: Los modelos de datos restrictivos, aunque elegantes, pueden limitar la capacidad de los estadísticos para trabajar en problemas nuevos y complejos. Las conclusiones se extraen sobre el mecanismo del modelo, no sobre el mecanismo de la naturaleza.

B. 2. La Cultura del Modelado Algorítmico (Algorithmic Modeling)

- Modelo de Complejidad: Surgió a mediados de los años 80 (con algoritmos como las redes neuronales y los árboles de decisión). Asume que la naturaleza es compleja y que los datos no necesariamente provienen de un modelo que pueda describirse de forma simple.

- Objetivo: Se enfoca principalmente en la predicción para futuras entradas (ej., predecir niveles de ozono o toxicidad química).

- Evaluación: Se evalúa midiendo la precisión predictiva.

Breiman señaló que el modelado algorítmico es a menudo más útil en entornos de consultoría y prácticos, y que la insistencia en los modelos restrictivos puede ser perjudicial: "Si todo lo que un hombre tiene es un martillo, entonces todo problema se parece a un clavo".

IV. La Tercera Cultura: Más Allá de la Predicción

Tras la consolidación del enfoque algorítmico, el campo continúa evolucionando. Se ha identificado que la precisión predictiva, si bien es crucial, no es el objetivo final.

- El Límite de la Precisión: La cultura algorítmica se preocupa solamente por la precisión predictiva. Sin embargo, en el dominio moderno (por ejemplo, con modelos de lenguaje masivos y datos virtualmente infinitos), esta perspectiva ya no es suficiente.

- La Búsqueda de la Capacidad: La "tercera cultura" propuesta en el modelado estadístico se desvía del modelado algorítmico al preocuparse fundamentalmente por la capacidad (capability) del modelo, incluyendo funciones como el razonamiento, la planificación y la resolución de problemas.

- No es Pura Estadística: Esta capacidad, argumentan los expertos, va más allá de un fenómeno puramente estadístico como el aprendizaje supervisado. Esto implica que se necesitan "nuevas ideas" para abordar las capacidades cognitivas en los modelos, lo que sugiere que la Ciencia de Datos está entrando en una fase de fundamentos teóricos aún más amplios y no puramente estadísticos.

Comentarios finales

La historia de los fundamentos de la Ciencia de Datos es una crónica de liberación: desde la liberación del yugo del rigor matemático absoluto (Tukey/Naur) hasta la liberación de los modelos restrictivos (Breiman). La disciplina ha pasado de la Descripción a la Predicción, y ahora se dirige hacia la Capacidad.

Para los profesionales de hoy, esta evolución subraya la necesidad de ser flexibles, adoptar el juicio empírico y continuar buscando herramientas (como las que Tukey sugirió en 1962, como FUNOP/FUNOM, incluso si son solo "indicaciones" en lugar de "conclusiones") que puedan revelar la verdad en datos complejos, sin limitarse a los modelos que ya conocemos.